编者按:企业数字化转型中,以文档、图像等多模态形式为载体的结构化分析和内容提取是其中的关键一环,快速、自动、精准地处理包括合同、票据、报告等信息,对提升现代企业生产效率至关重要。因此,文档智能技术应运而生。过去几年,微软亚洲研究院推出了通用文档理解预训练 LayoutLM 系列研究成果,并不断优化模型对文档中文本、布局和视觉信息的预训练性能。近期发表的最新的 LayoutLM 3.0 版本,在以文本和图像为中心的任务上有了更加出色的表现,让文档理解模型向跨模态对齐迈出一大步!

随着各行各业的数字化转型,涵盖表单、票据、邮件、合同、报告、论文等的电子文档数量持续增长。电子文档包含大量与行业相关的图像和文本信息,人工处理这些大量的信息耗时长、成本大。电子文档的自动识别、理解和分析技术对提高个人或企业的生产力十分重要,因此文档智能技术应运而生。文档智能利用计算机自动识别、理解及分析电子文档,大大提升了个人和企业处理电子文档的生产力,是自然语言处理和计算机视觉交叉领域的一个重要研究方向。

虽然为特定任务设计的深度学习方法针对某一项文档理解任务能取得较好的性能,但这些方法通常依赖于有限的标注数据,而对于文档理解任务尤其是其中的信息抽取任务来说,获取详细的标注数据昂贵且耗时。为此,微软亚洲研究院的研究人员将目光转向了那些被忽视的无标注数据上,通过自监督预训练技术来利用现实生活中大量的无标注数据。由于近年来预训练在深度学习领域被广泛应用,所以该技术在文档智能领域也取得了显著进展。经过预训练的文档智能模型可以解析并提取文档的各类信息,这对文档智能的学术研究和生产应用都有重要意义。

LayoutLMv3:距离文档理解跨模态对齐又进一步

现实生活中的文档不仅有大量的文本信息,同时也包含丰富的布局和视觉信息,并且这三种模态在文档中有天然的对齐特性。如何对这些文档进行建模并且通过训练达到跨模态对齐是一个重要的研究课题。对此,微软亚洲研究院在文档智能领域进行了诸多探索,推出了通用文档理解预训练 LayoutLM 系列研究成果。这些成果不仅在学术界受到了广泛关注和认可,在工业界也得到了广泛应用,如微软 Azure 认知服务中的表单识别器(Form Recognizer)等。

- LayoutLM——通过将文本和布局进行联合预训练,在多种文档理解任务上取得了显著提升。

- LayoutLMv2——通过将视觉特征信息融入到预训练过程中,大大提高了模型的图像理解能力。

- LayoutXLM——基于 LayoutLMv2 的模型结构,通过使用53种语言进行预训练,拓展了 LayoutLM 的多语言支持。

如今,微软亚洲研究院又提出了新一代的文档理解预训练模型 LayoutLMv3,通过简单的模型架构和统一的预训练目标,大大简化了模型设计,增强了下游任务的易用性。研究员们分别在5000万张中文和1100万张英文文档图像上预训练了 LayoutLMv3 模型,以满足广大中英文用户的需求。LayoutLMv3 在以文本为中心的任务中(如表单理解、小票理解和文档视觉问答)和在以图像为中心的任务中(如文档图像分类和文档布局分析)均有出色表现。

相关论文被计算机多媒体领域顶会 ACM Multimedia 2022 接收为 Oral Presentation(口头报告论文),代码及模型均已开源。(论文及代码链接,请见文末)

LayoutLMv3 以统一的文本和图像掩码建模目标来预训练多模态模型

自监督学习利用大量无标注数据,在表征学习中取得了快速进展。在自然语言处理研究中,BERT 首先提出了“掩码语言建模”(Masked Language Modeling, MLM)的自监督预训练方法,通过随机遮盖文本中一定比例的单词,并根据上下文重建被遮盖的单词来学习具有上下文语义的表征。虽然大多数用于文档智能的多模态预训练模型在语言模态上使用了 MLM,但它们在图像模态的预训练目标有所不同。例如,有的模型目标是重建密集的图像像素或是重建连续的局部区域特征,这些方法倾向于学习嘈杂的细节,而不是高层结构(如文档布局)。并且,图像和文本目标的粒度不同进一步增加了跨模态对齐学习的难度,而跨模态对齐学习对多模态表示学习非常关键。

为了克服文本和图像在预训练目标上的差异,促进多模态表征学习,微软亚洲研究院的研究员们提出了 LayoutLMv3,以统一的文本和图像掩码建模目标来预训练多模态模型,即 LayoutLMv3 学习重建语言模态的遮盖词 ID,并对称地重建图像模态的遮盖图像块 ID。

此外,对于文档来说,每个文本词都对应着一个图像块。为了学习这种跨模态的对齐关系,研究员们还提出了一个词块对齐预训练目标,通过预测一个文本词的对应图像块是否被遮盖,来学习这种语言——图像细粒度对齐关系。

LayoutLMv3 模型架构:直接利用文档图像的图像块,节省参数并避免区域标注

在模型架构设计上,LayoutLMv3 不依赖复杂的 CNN 或 Faster R-CNN 网络来表征图像,而是直接利用文档图像的图像块,从而大大节省了参数并避免了复杂的文档预处理(如人工标注目标区域框和文档目标检测)。简单的统一架构和训练目标使 LayoutLMv3 成为通用的预训练模型,可适用于以文本为中心和以图像为中心的文档 AI 任务。

微软亚洲研究院在五个数据集中评估了预训练的 LayoutLMv3 模型,包括以文本为中心的数据集:表单理解 FUNSD 数据集,票据理解 CORD 数据集,文档视觉问答 DocVQA 数据集;以及以图像为中心的数据集:文档图像分类 RVL-CDIP 数据集,文档布局分析 PubLayNet 数据集。实验结果表明,LayoutLMv3 在这些数据集上以更少的参数达到了更优的性能。

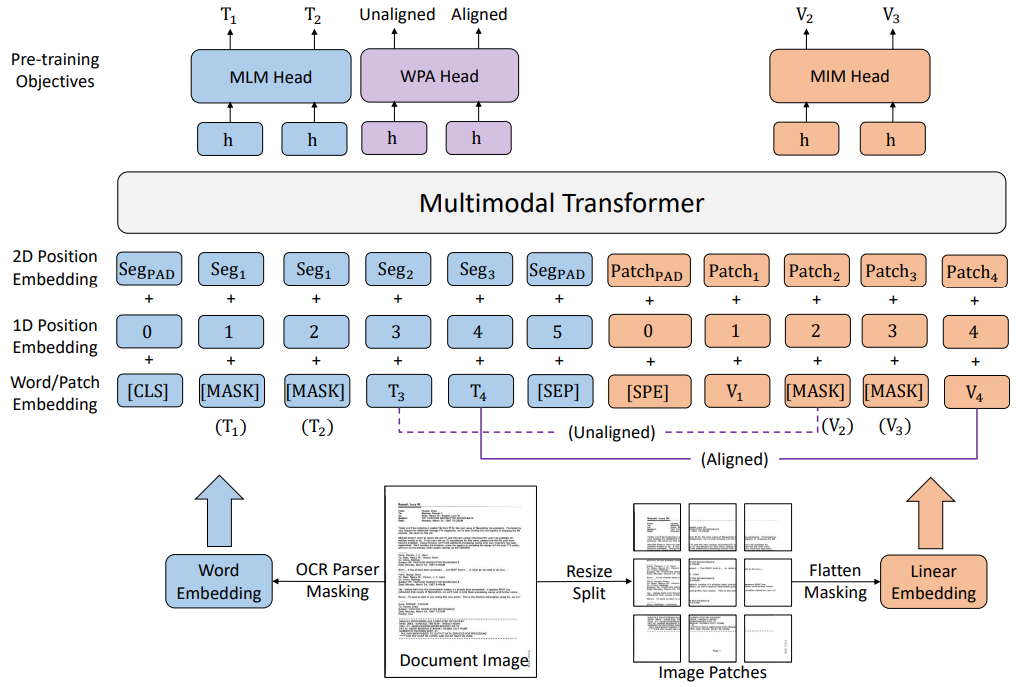

LayoutLMv3 还应用了文本——图像多模态 Transformer 架构来学习跨模态表征。文本向量由词向量、词的一维位置向量和二维位置向量相加得到。文档图像的文本和其相应的二维位置信息(布局信息)则利用光学字符识别(OCR)工具抽取。因为文本的邻接词通常表达了相似的语义,LayoutLMv3 共享了邻接词的二维位置向量,而 LayoutLM 和 LayoutLMv2 的每个词则用了不同的二维位置向量。

图像向量的表示通常依赖于 CNN 抽取特征图网格特征或 Faster R-CNN 提取区域特征,这些方式增加了计算开销或依赖于区域标注。因此,研究员们将图像块经过线性映射获得图像特征,这种图像表示方式最早在 ViT 中被提出,计算开销极小且不依赖于区域标注,有效解决了以上问题。具体来说,首先将图像缩放为统一的大小(例如224×224),然后将图像切分成固定大小的块(例如16×16),并通过线性映射获得图像特征序列,再加上可学习的一维位置向量后得到图像向量。

LayoutLMv3 通过三个预训练目标以自监督的方式学习多模态表示

掩码语言建模(Masked Language Modeling, MLM)。为了利于模型学习布局信息与文本和图像之间的对应关系,该任务随机遮盖30%的文本词向量,但保留对应的二维位置(布局)信息。类似 BERT 和 LayoutLM,模型目标是根据未被遮盖的图文和布局信息还原文本中被遮盖的词。

掩码图像建模(Masked Image Modeling, MIM)。为了鼓励模型从文本和图像的上下文信息推测图像信息,该任务随机遮盖了约40%的图像块。类似 BEiT,模型目标是根据未被遮盖的文本和图像的信息还原被遮盖的图像块经过离散化的 ID。

词块对齐(Word-Patch Alignment, WPA)。对于文档来说,每个文本词都对应着一个图像块。由于前两个任务随机遮盖了部分文本词和图像块,模型无法显式地学习这种文本词和图像块之间的细粒度对齐关系。该目标通过显式地预测一个文本词的对应图像块是否被掩盖来学习语言和视觉模态之间的细粒度对齐关系。

实验及结果

为了学习各种文档任务的通用表示,LayoutLMv3 的预训练数据集是 IIT-CDIP,包含大约1100万张扫描文档图像。微软亚洲研究院训练了 BASE、LARGE 两种规模的模型,参数量分别是133M、368M。

1. 微调多模态任务:远超 SOTA

研究员们在四个多模态任务上对 LayoutLMv3 进行了微调:

(1)表单理解任务对表单的文本内容进行序列标注。FUNSD 是一个文档扫描表单理解数据集,包含199个文档,有9,707个语义实体的标注。FUNSD 数据集的语义实体标签任务旨在为每个语义实体分类为“问题”、“答案”、“标题”或“其他”中的一个。

(2)票据理解任务需要提取票据信息,对每个词进行语义标签分类。该任务的数据集是 CORD,它包含1,000张收据,在4个类别下定义了30个语义标签。

(3)文档图像分类任务的目的是预测文档图像的类别。该任务在 RVL-CDIP 数据集上进行。RVL-CDIP 数据集包含400,000张文档图像,标有16个类别。

(4)文档视觉问答任务需要模型将文档图像和问题作为输入,并输出一个答案。该任务在DocVQA数据集上进行。DocVQA 的训练集包含约一万张图片和四万个问题。

在这些任务上,LayoutLMv3 取得了比以前的工作更好或相当的结果。例如,对于LARGE模型规模,LayoutLMv3 在 FUNSD 数据集上取得了92.08的 F1 分数,大大超过了此前 LARGE 规模的 SOTA 结果(85.14)。

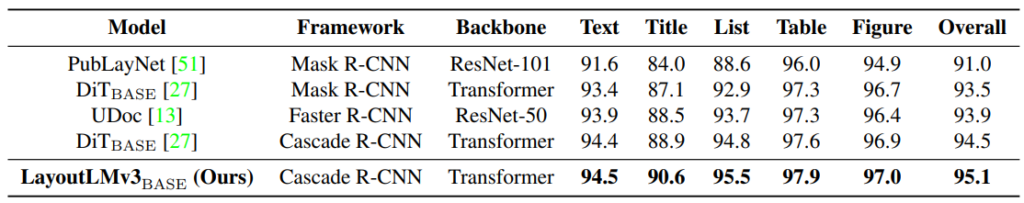

2. 微调视觉任务:所有指标优于其他模型

为了证明多模态预训练模型 LayoutLMv3 在视觉领域应用的通用性,研究员们将 LayoutLMv3 应用于了文档布局分析任务。文档布局分析任务旨在为文档的不同布局元素检测二维位置和类别。这项任务有助于将文档解析成机器可读的格式,供下游应用程序使用。研究员们将这项任务建模为目标检测问题,以 LayoutLMv3 为特征提取网络,将不同层提取的特征整合到目标检测器中。研究员们在 PubLayNet 数据集上进行了实验。该数据集包含三十多万张研究论文图像,每张图像都有布局边界框的位置和类别标注,类别涵盖文本、标题、列表、图和表。与卷积神经网络模型和同期的视觉 Transformer 预训练模型相比,LayoutLMv3 在所有指标上都优于其他模型。

3. 消融实验:有力证明了 LayoutLMv3 适合以图像为中心的文档分析任务

为了研究 LayoutLMv3 的图像表示方法和预训练目标的效果,研究员们在四个典型的数据集上进行了消融实验。基础模型只使用文本和布局信息,用 MLM 目标进行预训练。接着,研究员们依次为基础模型增加图像表示,MIM 和 WPA 预训练目标。

通过表格中的结果,可观察到,基础模型没有图像表示,不能进行以图像为中心的文档分析任务。LayoutLMv3 采用图像块的线性映射作为图像表示,设计简单,只引入了0.6M的参数。这种图像表示通过与 MIM 预训练目标结合,不仅能支持以图像为中心的任务,还能提升以文本为中心的任务的表现。结合 WPA 预训练目标又进一步提升了所有下游任务的性能,证实了 WPA 在跨模态表示学习和图像表示学习中的有效性,强调了视觉和语言跨模态对齐学习的重要性。此外,研究员们还发现 MIM 可以帮助规范化训练,对于 PubLayNet 上的文档布局分析等视觉任务的模型收敛至关重要。

LayoutLMv3 用于中文文档理解也有出色表现

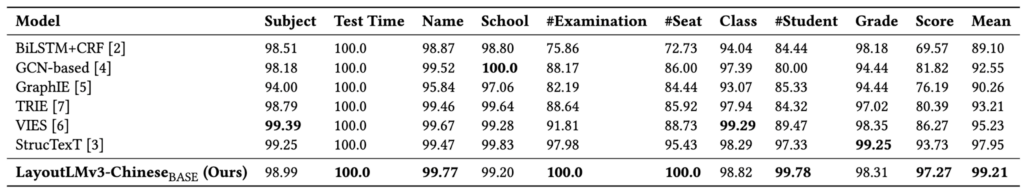

以上描述的 LayoutLMv3 模型的预训练数据均为英语,可在英语的下游任务数据集上微调。为了满足广大中文用户的需求,研究员们还训练了中文的 LayoutLMv3 模型,可用于中文任务。

研究员们通过大规模数据抓取获得了海量的数字文档,并用自动化语言检测工具筛选出了5000万张中文文档图像用于预训练。研究员们在一个中文视觉信息抽取任务上验证了模型的效果。由表4可见,LayoutLMv3 在所有类别平均分数上取得了99.21的高分,显著超过了其他模型,验证了 LayoutLMv3 中文模型的有效性。

大量的实验结果都证明了 LayoutLMv3 的通用性和优越性,它不仅适用于以文本为中心和以图像为中心的文档智能任务,还可以以更少的参数获得更好或相当的性能。未来,微软亚洲研究院将探索扩大预训练模型的规模,使模型能够利用更多的训练数据来进一步推动结果;同时扩展模型的少样本学习能力,从而促进模型在文档智能行业中更多业务场景下的应用。

LayoutLMv3 论文链接:https://arxiv.org/pdf/2204.08387.pdf

LayoutLMv3 代码链接:https://aka.ms/layoutlmv3